Ottica quantistica. Fisica del micromondo. Fisica molecolare.

Radiazione termica- radiazione elettromagnetica a spettro continuo, emessa da corpi riscaldati per effetto della loro energia termica.

Esempio La radiazione termica è la luce proveniente da una lampada a incandescenza.

La potenza della radiazione termica di un oggetto che soddisfa i criteri di un corpo nero assoluto è descritta da Legge di Stefan-Boltzmann.

Viene descritta la relazione tra le capacità emissive e assorbenti dei corpi Legge sulle radiazioni di Kirchhoff.

La radiazione termica è uno dei tre tipi elementari di trasferimento di energia termica.

La radiazione di equilibrio è la radiazione termica che è in equilibrio termodinamico con la materia.

Le principali caratteristiche quantitative della radiazione termica sono:

- luminosità energetica

è la quantità di energia della radiazione elettromagnetica nell'intero intervallo di lunghezze d'onda della radiazione termica emessa da un corpo in tutte le direzioni da un'unità di superficie per unità di tempo: R = E/(S t), [J/(m 2 s)] = [W /m 2 ] La luminosità energetica dipende dalla natura del corpo, dalla temperatura del corpo, dallo stato della superficie del corpo e dalla lunghezza d'onda della radiazione.

- densità di luminosità spettrale

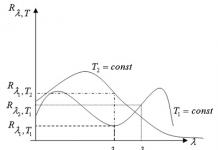

- luminosità energetica di un corpo per date lunghezze d'onda (λ + dλ) ad una data temperatura (T + dT): R λ, T = f(λ, T).

La luminosità energetica di un corpo entro determinate lunghezze d'onda si calcola integrando R λ, T = f(λ, T) per T = const:

coefficiente di assorbimento- il rapporto tra l'energia assorbita dal corpo e l'energia incidente. Quindi, se la radiazione proveniente da un flusso dФ inc cade su un corpo, una parte di essa viene riflessa dalla superficie del corpo - dФ neg, l'altra parte passa nel corpo e si trasforma parzialmente in calore dФ abs, e la terza parte , dopo varie riflessioni interne, attraversa il corpo verso l'esterno dФ inc : α = dФ ass./dФ giù.

Legge di Stefan-Boltzmann- la legge della radiazione del corpo nero. Determina la dipendenza della potenza radiante di un corpo assolutamente nero dalla sua temperatura. Dichiarazione della legge:

dov'è il grado di nerezza (per tutte le sostanze, per un corpo assolutamente nero). Utilizzando la legge di Planck per la radiazione, la costante può essere definita come:

![]()

dove è la costante di Planck, è la costante di Boltzmann e è la velocità della luce.

Valore numerico J s −1 m −2 K −4.

La legge è stata scoperta indipendentemente da J. Stefan e L. Boltzmann partendo dal presupposto che la densità di energia della radiazione è proporzionale alla sua pressione. Confermato da Leo Graetz nel 1880.

È importante notare che la legge parla solo dell'energia totale emessa. La distribuzione dell'energia sullo spettro della radiazione è descritta dalla formula di Planck, secondo la quale esiste un unico massimo nello spettro, la cui posizione è determinata dalla legge di Wien.

Legge sulle radiazioni di Kirchhoff.

Nel moderno formulazione 3 La legge è questa:

Il rapporto tra l'emissività di qualsiasi corpo e la sua capacità di assorbimento è lo stesso per tutti i corpi ad una data temperatura per una data frequenza e non dipende dalla loro forma e natura chimica.

È noto che quando la radiazione elettromagnetica cade su un determinato corpo, parte di essa viene riflessa, parte viene assorbita e parte può essere trasmessa. Viene chiamata la frazione di radiazione assorbita ad una data frequenza capacità di assorbimento corpo. D'altra parte, ogni corpo riscaldato emette energia secondo una legge chiamata emissività del corpo.

I valori di e possono variare notevolmente quando ci si sposta da un corpo all'altro, tuttavia, secondo la legge di radiazione di Kirchhoff, il rapporto tra capacità emissiva e di assorbimento non dipende dalla natura del corpo ed è una funzione universale della frequenza ( lunghezza d'onda) e temperatura:

![]()

Per definizione, un corpo assolutamente nero assorbe tutta la radiazione incidente su di esso, cioè per esso. Pertanto, la funzione coincide con l'emissività di un corpo assolutamente nero, descritta dalla legge di Stefan-Boltzmann, per cui l'emissività di qualsiasi corpo può essere trovata solo in base alla sua capacità di assorbimento.

I corpi reali hanno una capacità di assorbimento inferiore all'unità, e quindi un'emissività inferiore a quella di un corpo assolutamente nero. I corpi la cui capacità di assorbimento non dipende dalla frequenza sono detti grigi. I loro spettri hanno lo stesso aspetto di quello di un corpo assolutamente nero. Nel caso generale, la capacità di assorbimento dei corpi dipende dalla frequenza e dalla temperatura, e il loro spettro può differire significativamente dallo spettro di un corpo assolutamente nero. Lo studio dell'emissività di diverse superfici fu condotto per la prima volta dallo scienziato scozzese Leslie utilizzando la sua invenzione: il cubo di Leslie.

Effetto fotoelettrico (effetto fotoelettrico) è il fenomeno dell'interazione della luce con la materia, a seguito della quale l'energia dei fotoni viene trasferita agli elettroni della sostanza. Per solido e liquido i corpi variano fotoeffetto esterno ed interno. Con esterno Nell'effetto fotoelettrico l'assorbimento dei fotoni è accompagnato dall'emissione di elettroni all'esterno del corpo. Con interno Nell'effetto fotoelettrico, gli elettroni strappati agli atomi, alle molecole e agli ioni rimangono all'interno della sostanza, ma le energie degli elettroni cambiano. Nei gas L'effetto fotoelettrico consiste nel fenomeno della fotoionizzazione: la rimozione di elettroni da atomi e molecole di gas sotto l'influenza della luce.

Visione qualitativa della caratteristica corrente-tensione la fotocellula, cioè la dipendenza della fotocorrente dalla tensione tra catodo e anodo nel caso di un flusso luminoso costante incidente sul catodo, è presentata in Fig. 1.13.

|

| Riso. 1.13. |

Tensione positiva corrisponde al campo elettrico accelerato in cui cadono gli elettroni che fuoriescono dal catodo. Pertanto, nella regione delle tensioni positive, tutti gli elettroni emessi dal catodo raggiungono l'anodo, provocando fotocorrente di saturazione.

Una leggera diminuzione della fotocorrente a un piccolo positivo la tensione, osservata negli esperimenti, è associata alla differenza di potenziale di contatto tra catodo e anodo. Di seguito, quando discuteremo le leggi dell'effetto fotoelettrico, trascureremo l'influenza della differenza di potenziale di contatto.

A tensione negativa Un elettrone emesso dal catodo entra in un campo elettrico frenante, che può superare solo se dispone di un certo apporto di energia cinetica. Un elettrone con bassa energia cinetica, uscito dal catodo, non può superare il campo frenante e raggiungere l'anodo. Un tale elettrone ritorna al catodo senza contribuire alla fotocorrente. Pertanto, una diminuzione graduale della fotocorrente nella regione delle tensioni negative indica che i fotoelettroni che fuoriescono dal catodo hanno valori di energia cinetica diversi.

Ad una certa tensione negativa, il cui valore è chiamato tensione di ritardo (potenziale), la fotocorrente diventa uguale a zero. Il corrispondente campo elettrico decelerante ritarda la fuga di tutti gli elettroni dal catodo, compresi gli elettroni con la massima energia cinetica.

Misurando la tensione di ritardo, dalla relazione è possibile determinare questa energia massima o velocità massima dei fotoelettroni

| . | (1.54) |

Sono stati stabiliti sperimentalmente i seguenti principi base dell’effetto fotoelettrico:

1. Per la luce monocromatica di una certa lunghezza d'onda, la fotocorrente di saturazione è proporzionale al flusso luminoso incidente sul catodo.

2.L'energia cinetica massima dei fotoelettroni non dipende dall'entità del flusso luminoso, ma è determinata solo dalla frequenza della radiazione.

3. Ciascuna sostanza catodica ha una propria frequenza di taglio tale che la radiazione con la frequenza dell'effetto fotoelettrico non provoca l'effetto fotoelettrico. Questa frequenza di taglio è chiamata frequenza di taglio rossa dell'effetto fotoelettrico. Sulla scala delle lunghezze d'onda corrisponde alla lunghezza d'onda del confine rosso, in modo tale che l'effetto fotoelettrico di un dato metallo provoca radiazioni solo con una lunghezza d'onda più corta.

(1.55) viene chiamato Equazione di Einstein per l'effetto fotoelettrico esterno. Ecco l'energia massima dei fotoelettroni.

Una conseguenza diretta di questa equazione è la seconda e la terza legge dell'effetto fotoelettrico. Infatti, dalla (1.55) segue che l'energia massima dei fotoelettroni dipende dalla frequenza della radiazione incidente sul metallo. Inoltre, se , l'effetto fotoelettrico non dovrebbe essere osservato. Da qui, per la frequenza e la lunghezza d'onda del confine rosso dell'effetto fotoelettrico, otteniamo semplici formule

da cui ne consegue che queste caratteristiche sono completamente determinate dal valore della funzione lavoro dell'elettrone dal metallo.

Fotone- una particella elementare, un quanto di radiazione elettromagnetica (in senso stretto - luce). È una particella priva di massa che può esistere solo muovendosi alla velocità della luce. La carica elettrica di un fotone è zero. Un fotone può trovarsi solo in due stati di spin con una proiezione dello spin sulla direzione del movimento (elicità) ±1. Questa proprietà nell'elettrodinamica classica corrisponde alla polarizzazione circolare destra e sinistra di un'onda elettromagnetica. Il fotone, in quanto particella quantistica, è caratterizzato dalla dualità onda-particella; esibisce contemporaneamente le proprietà di una particella e di un'onda. I fotoni sono indicati con la lettera , motivo per cui sono spesso chiamati quanti gamma (soprattutto fotoni ad alta energia); questi termini sono praticamente sinonimi. Dal punto di vista del Modello Standard, il fotone è un bosone di gauge. I fotoni virtuali sono portatori di forza elettromagnetica, fornendo così l'interazione, ad esempio, tra due cariche elettriche. Il fotone è la particella più abbondante nell’Universo. Ci sono almeno 20 miliardi di fotoni per nucleone.

Dualità onda-corpuscolo, Principio di indeterminazione di Heisenberg

Il fotone è caratterizzato dalla dualità onda-particella. Da un lato, un fotone dimostra le proprietà di un'onda elettromagnetica nei fenomeni di diffrazione e interferenza se le dimensioni caratteristiche degli ostacoli sono paragonabili alla lunghezza d'onda del fotone. Ad esempio, una sequenza di singoli fotoni con una frequenza che passa attraverso una doppia fenditura crea sullo schermo una figura di interferenza che può essere descritta dalle equazioni di Maxwell. Tuttavia, gli esperimenti mostrano che i fotoni vengono emessi e assorbiti interamente da oggetti che hanno dimensioni molto inferiori alla lunghezza d'onda del fotone (ad esempio gli atomi), o che in generale, con una certa approssimazione, possono essere considerati puntiformi (proprio come, ad esempio, gli elettroni). . Pertanto, i fotoni nei processi di emissione e assorbimento si comportano come particelle puntiformi. Allo stesso tempo, questa descrizione non è sufficiente; l'idea di un fotone come particella puntiforme, la cui traiettoria è specificata probabilisticamente da un campo elettromagnetico, è confutata da esperimenti di correlazione con stati entangled di fotoni.

Esperimento mentale di Heisenberg per determinare la posizione dell'elettrone (ombreggiato in blu) utilizzando un microscopio a raggi gamma ad alta risoluzione.

I raggi gamma incidenti (mostrati in verde) vengono diffusi dall'elettrone ed entrano nell'angolo di apertura del microscopio θ. I raggi gamma sparsi sono mostrati in rosso nella figura. L'ottica classica mostra che la posizione di un elettrone può essere determinata solo fino a un certo valore Δ X, che dipende dall'angolo θ e dalla lunghezza d'onda λ dei raggi incidenti.

L'elemento chiave della meccanica quantistica è Principio di indeterminazione di Heisenberg, che vieta la determinazione simultanea precisa della coordinata spaziale di una particella e del suo momento lungo tale coordinata.

È importante notare che la quantizzazione della luce e la dipendenza dell'energia e della quantità di moto dalla frequenza sono necessarie per soddisfare il principio di indeterminazione applicato a una particella massiccia carica. Ciò può essere illustrato dal famoso esperimento mentale con un microscopio ideale, che determina le coordinate di un elettrone irradiandolo con luce e registrando la luce diffusa (microscopio gamma Heisenberg). La posizione dell'elettrone può essere determinata con una precisione pari alla risoluzione del microscopio. Basato sui concetti dell’ottica classica:

dove è l'angolo di apertura del microscopio. Pertanto, l'incertezza delle coordinate può essere ridotta a piacere riducendo la lunghezza d'onda dei raggi incidenti. Tuttavia, dopo la diffusione, l'elettrone acquisisce ulteriore quantità di moto, la cui incertezza è pari a . Se la radiazione incidente non fosse quantizzata, questa incertezza potrebbe essere resa arbitrariamente piccola riducendo l’intensità della radiazione. La lunghezza d'onda e l'intensità della luce incidente possono essere modificate indipendentemente l'una dall'altra. Di conseguenza, in assenza di quantizzazione della luce, sarebbe possibile determinare simultaneamente con elevata precisione la posizione dell'elettrone nello spazio e la sua quantità di moto, il che contraddice il principio di indeterminazione.

Al contrario, la formula di Einstein per la quantità di moto del fotone soddisfa pienamente i requisiti del principio di indeterminazione. Tenendo conto del fatto che un fotone può essere diffuso in qualsiasi direzione all’interno dell’angolo, l’incertezza della quantità di moto trasferita all’elettrone è pari a:

![]()

Moltiplicando la prima espressione per la seconda si ottiene la relazione di incertezza di Heisenberg: . Pertanto, il mondo intero è quantizzato: se la materia obbedisce alle leggi della meccanica quantistica, allora il campo deve obbedirvi e viceversa.

Gli esperimenti di Rutherford portarono alla conclusione che al centro dell'atomo c'è un nucleo denso e carico positivamente (nucleo atomico, da qui il nome del modello), il cui diametro non supera i 10–14–10–15 M. Questo nucleo occupa solo 10–12 parti del volume totale dell'atomo, ma contiene Tutto carica positiva e almeno il 99,95% della sua massa. Alla sostanza che costituisce il nucleo dell'atomo avrebbe dovuto essere assegnata una densità colossale dell'ordine di ρ ≈ 10 15 g/cm 3 . La carica del nucleo deve essere uguale alla carica totale di tutti gli elettroni che compongono l'atomo. Successivamente, è stato possibile stabilire che se la carica dell'elettrone viene presa come una, la carica del nucleo è esattamente uguale al numero di questo elemento nella tavola periodica.

Figura 6.1.3 Diffusione di una particella α in un atomo di Thomson (a) e in un atomo di Rutherford (b)

Successivamente, Rutherford propose modello planetario dell'atomo . Secondo questo modello, al centro dell'atomo si trova un nucleo carico positivamente, nel quale è concentrata quasi tutta la massa dell'atomo. L'atomo nel suo insieme è neutro. Gli elettroni ruotano attorno al nucleo, come i pianeti, sotto l'influenza delle forze di Coulomb provenienti dal nucleo (Fig. 6.1.4). Gli elettroni non possono essere fermi perché cadrebbero sul nucleo.

Riso. 6.1.4. Modello planetario dell'atomo di Rutherford. Sono mostrate le orbite circolari di quattro elettroni

Nucleo atomico- la parte centrale dell'atomo, in cui è concentrata la maggior parte della sua massa (oltre il 99,9%). Il nucleo è carico positivamente; la carica del nucleo è determinata dall'elemento chimico a cui appartiene l'atomo. Le dimensioni dei nuclei di vari atomi sono diversi femtometri, ovvero più di 10mila volte inferiori alla dimensione dell'atomo stesso. Il nucleo atomico è costituito di nucleoni - protoni caricati positivamente e neutroni neutri, che sono collegati tra loro attraverso una forte interazione. Il numero di protoni in un nucleo è chiamato suo numero di addebito- questo numero è uguale al numero seriale dell'elemento a cui appartiene l'atomo nella serie naturale degli elementi della tavola periodica. Il numero di protoni nel nucleo determina la struttura del guscio elettronico di un atomo neutro e, quindi, le proprietà chimiche dell'elemento corrispondente. Il numero di neutroni in un nucleo è chiamato suo numero isotopico. I nuclei con lo stesso numero di protoni e diverso numero di neutroni sono detti isotopi. Vengono chiamati nuclei con lo stesso numero di neutroni ma diverso numero di protoni isotoni. Il numero totale di nucleoni in un nucleo è chiamato suo numero di Massa() ed è approssimativamente uguale alla massa atomica media indicata nella tavola periodica. Vengono solitamente chiamati nuclidi con lo stesso numero di massa, ma diversa composizione protone-neutrone isobare. Come ogni sistema quantistico, i nuclei possono trovarsi in uno stato eccitato metastabile e in alcuni casi la durata di tale stato è calcolata in anni. Vengono chiamati tali stati eccitati dei nuclei isomeri nucleari. Quasi il 90% dei 2.500 nuclei atomici conosciuti sono instabili. Un nucleo instabile si trasforma spontaneamente in altri nuclei, emettendo particelle. Questa proprietà dei nuclei si chiama radioattività. Si è scoperto che i nuclei radioattivi possono emettere particelle di tre tipi: cariche positivamente e negativamente e neutre. Questi tre tipi di radiazioni furono chiamati Radiazioni α, β e γ. Questi tre tipi di radiazioni radioattive differiscono molto tra loro per la loro capacità di ionizzare gli atomi della materia e, quindi, per la loro capacità di penetrazione. Ha la capacità di penetrazione più bassa radiazione α. Nell'aria, in condizioni normali, i raggi α percorrono una distanza di diversi centimetri . raggi β molto meno assorbito dalla sostanza. Sono in grado di passare attraverso uno strato di alluminio spesso diversi millimetri. Avere la massima capacità di penetrazione raggi γ, capace di passare attraverso uno strato di piombo spesso 5–10 cm.

Divisione rappresenta il decadimento (scissione) di un nucleo atomico in due ca. parti uguali (frammenti), accompagnati dal rilascio di energia e, nel dipartimento. casi, emettendo uno o più. particelle, ad esempio i neutroni. Alcuni nuclei pesanti possono scindersi spontaneamente, mentre quelli più leggeri possono scindersi in caso di collisione con altri nuclei ad alta energia. Inoltre, i nuclei pesanti, come gli atomi di uranio, sono capaci di fissione quando bombardati da neutroni e, poiché vengono emessi nuovi neutroni, il processo può diventare autosufficiente, vale a dire. si verifica una reazione a catena. Durante una tale reazione di fissione, viene rilasciata una grande quantità di energia. Nei reattori nucleari si verificano reazioni a catena controllate, mentre in una bomba atomica si verificano reazioni a catena incontrollate. Sintesiè la fusione dei nuclei di due atomi leggeri per formare un nuovo nucleo corrispondente ad un atomo più pesante. Se questo nuovo nucleo è stabile, durante la fusione viene rilasciata energia, poiché i legami in esso contenuti sono più forti che nei nuclei originali. Da chimica. Le reazioni di fusione nucleare si distinguono per la partecipazione non solo degli elettroni degli atomi, ma anche dei loro nuclei. Per unità di massa di sostanze reagenti nella reazione di fusione nucleare, ca. 10 volte più energia delle reazioni di fissione. La sintesi dei nuclei avviene al centro, nella regione del Sole e delle altre stelle, essendo la fonte della loro energia. Una reazione incontrollata di tale sintesi si realizza nelle bombe all'idrogeno. Al giorno d'oggi, vengono condotte ricerche sull'implementazione di reazioni controllate di tale sintesi come fonti di energia.

Particella elementare- termine collettivo che si riferisce a microoggetti su scala subnucleare che non possono essere scomposti nelle loro parti componenti.

Va tenuto presente che alcune particelle elementari (elettrone, fotone, quark, ecc.) sono attualmente considerate prive di struttura e sono considerate particelle fondamentali primarie. Altre particelle elementari (le cosiddette particelle composite - protone, neutrone, ecc.) hanno una struttura interna complessa, ma, tuttavia, secondo i concetti moderni, è impossibile separarle in parti.

Particella fondamentale- una particella elementare priva di struttura, che finora non è stata descritta come composita. Attualmente, il termine è usato principalmente per leptoni e quark (6 particelle di ciascun tipo, insieme alle antiparticelle, compongono un insieme di 24 particelle fondamentali) insieme ai bosoni di calibro (particelle che trasportano interazioni fondamentali).

Teoria cinetica molecolare interpreta le proprietà dei corpi direttamente osservati sperimentalmente (pressione, temperatura, ecc.) come il risultato totale dell'azione delle molecole. Per fare ciò, utilizza il metodo statistico, interessandosi non al movimento delle singole molecole, ma solo ai valori medi che caratterizzano il movimento di un enorme insieme di particelle. Da qui il suo altro nome - fisica statistica.

Parametri termodinamici- temperatura, densità, pressione, volume, resistività elettrica e altre grandezze fisiche:

- determinare in modo inequivocabile lo stato termodinamico del sistema;

- non tengono conto della struttura molecolare dei corpi; E

- descriverne la struttura macroscopica.

Sulla base dell'uso dei principi di base della teoria cinetica molecolare, è stato ottenuto equazione base del gas ideale MKT, che assomiglia a questo: , dove p è la pressione di un gas ideale, m0 è la massa della molecola, il valore medio della concentrazione delle molecole, il quadrato della velocità delle molecole.

Denotando il valore medio dell'energia cinetica del movimento traslazionale delle molecole di un gas ideale, otteniamo equazione MKT di base gas ideale nella forma:

Nella teoria dei gas ideali l'energia potenziale di interazione tra le molecole è considerata pari a zero. Ecco perché L'energia interna di un gas ideale è data da energia cinetica di movimento di tutte le sue molecole. L'energia media di movimento di una molecola è . Poiché una chilomole contiene molecole, l'energia interna di una chilomole di gas sarà ![]()

Considerando ciò, otteniamo

Per qualsiasi massa di gas m, cioè. per qualsiasi numero di kilomoli Energia interna

| (10.12) |

Da questa espressione ne consegue che l'energia internaè una funzione inequivocabile dello stato e, pertanto, quando il sistema esegue un processo, a seguito del quale il sistema ritorna al suo stato originale, la variazione totale dell'energia interna è pari a zero. Matematicamente, questo è scritto come identità

Seconda legge della termodinamica afferma che tutti i processi irreversibili (e tali sono quasi tutti i processi termici, in ogni caso tutti i processi naturali) procedono così, che l’entropia delle persone coinvolte in essi i corpi aumentano, tendendo al valore massimo. Il valore massimo di entropia si raggiunge quando il sistema raggiunge uno stato di equilibrio.

Allo stesso tempo, è già stato notato sopra che la transizione verso uno stato di equilibrio è molto più probabile rispetto a tutte le altre transizioni. Si osservano quindi solo quei cambiamenti di stato in cui il sistema passa da uno stato meno probabile ad uno più probabile (la probabilità termodinamica aumenta).

Relazione tra la probabilità termodinamica dello stato di un sistema e la sua entropiaè stata fondata nel 1875 da due famosi scienziati: D. Gibbs e L. Boltzmann. Questa connessione è espressa La formula di Boltzmann, che assomiglia a:

| , | (4.56) |

Dove , R– costante universale dei gas, N / A– Numero di Avogadro.

Equazione di stato dei gas ideali(a volte l'equazione di Clapeyron o l'equazione di Mendeleev-Clapeyron) è una formula che stabilisce la relazione tra pressione, volume molare e temperatura assoluta di un gas ideale. L'equazione è simile a:

Pressione,

volume molare,

Costante universale dei gas

Temperatura assoluta, K.

Poiché , dove è la quantità di sostanza, e , dove è la massa, è la massa molare, l'equazione di stato può essere scritta:

Si può vedere che questa equazione è in realtà l'equazione di stato di un gas ideale con due correzioni. La correzione tiene conto delle forze attrattive tra le molecole (la pressione sulla parete diminuisce, poiché ci sono forze che tirano verso l'interno le molecole dello strato limite), la correzione tiene conto delle forze repulsive (sottraiamo il volume occupato dalle molecole dal volume totale).

Per moli di gas Van L’equazione di stato di der Waals si presenta così:

Dov'è il volume?

Dov'è il volume?

Isoterma una linea su un diagramma di fase che rappresenta un processo che avviene a temperatura costante (processo isotermico). L'equazione Isoterma gas ideale pV = cost, dove p è la pressione, V è il volume del gas. Per un gas reale, l'equazione Isoterma ha un carattere più complesso e rientra nell'equazione Isoterma gas ideale solo a basse pressioni o alte temperature.

Nella fig. 2.8 schematicamente vengono mostrate le isoterme del gas van der Waals per temperature diverse.

Queste isoterme mostrano chiaramente l'area in cui la pressione aumenta con l'aumentare del volume. Quest'area non ha alcun significato fisico. Nella regione in cui l'isoterma fa una curva a zigzag, l'isoterma la interseca tre volte, cioè ci sono tre valori di volume per gli stessi valori dei parametri e . All'aumentare della temperatura la sezione ondulatoria diminuisce e si trasforma in un punto (vedi punto K in Fig. 2.8). Questo punto si chiama critico, il cui valore dipende dalle proprietà del gas.

Isoterme del gas reale (schematicamente)

Isoterme del gas reale (schematicamente)

Blu: isoterme a temperature inferiori a quelle critiche. Le aree verdi su di essi rappresentano stati metastabili.

L'area a sinistra del punto F è normalmente liquida.

Il punto F è il punto di ebollizione.

FG diretto - equilibrio delle fasi liquida e gassosa.

Sezione FA - liquido surriscaldato.

Sezione F′A - fluido disteso (p<0).

La sezione AC è una continuazione analitica dell'isoterma ed è fisicamente impossibile.

Sezione CG - vapore superraffreddato.

Il punto G è il punto di rugiada.

L'area a destra del punto G è gas normale.

Le aree della figura FAB e GCB sono uguali.

Il rosso è l'isoterma critica.

K è il punto critico.

Blu: isoterme supercritiche

Poiché l'intero processo avviene a temperatura costante T, una curva che rappresenta la dipendenza della pressione p dal volume V, chiamata isoterma. Al volume V 1 inizia la condensazione del gas e al volume V 2 termina. Se V > V 1 allora la sostanza sarà allo stato gassoso, mentre se V< V 2 - в жидком.

Gli esperimenti lo dimostrano Anche le isoterme di tutti gli altri gas hanno questa forma se la loro temperatura non è molto elevata.

In questo processo, quando un gas si trasforma in liquido quando il suo volume cambia da V 1 a V 2, la pressione del gas rimane costante. Ogni punto della parte lineare dell'isoterma 1-2 corrisponde ad un equilibrio tra lo stato gassoso e quello liquido della sostanza. Ciò significa che è certo T E V la quantità di liquido e gas sopra di esso rimane invariata. L'equilibrio è dinamico: il numero di molecole che lasciano i liquidi è, in media, pari al numero di molecole che passano contemporaneamente dal gas al liquido.

Esiste anche una cosa come temperatura critica, se un gas si trova a una temperatura superiore alla temperatura critica (individuale per ciascun gas, ad esempio, per l'anidride carbonica circa 304 K), non può più essere trasformato in liquido, indipendentemente dalla pressione ad esso applicata. Questo fenomeno si verifica perché ad una temperatura critica le forze di tensione superficiale del liquido sono pari a zero. Se si continua a comprimere lentamente un gas ad una temperatura superiore alla temperatura critica, dopo che ha raggiunto un volume pari a circa quattro dei volumi intrinseci delle molecole che compongono il gas, la comprimibilità del gas inizia a diminuire bruscamente.

Breve riassunto della fisica moderna del micromondo :

1 . Il micromondo è costituito da due tipi di particelle, che differiscono principalmente per le dimensioni: dalle particelle del mondo ultramicro ( Per esempio , fotone ) e particelle del micromondo ( Per esempio , elettrone ). Il mondo ultramicro è tre ordini di grandezza più piccolo delle particelle del micromondo . Di solito 10 alla meno diciottesima potenza .

2. Quindi abbiamo tre direzioni di movimento delle particelle ( riso .1 ) E , rispettivamente , tre spazi per i campi : campo gravitazionale , campo elettrico e magnetico . Su questa base, possiamo parlare della natura unificata di tutti e tre i campi e basta , che tutti e tre i campi sono inseparabili l'uno dall'altro nel microcosmo . ( Ci sono sostanze in natura , creando campi magnetici o campi elettrici separatamente ). Come conseguenza di questa affermazione, se un conduttore di corrente elettrica viene introdotto in un campo magnetico , allora non può essere influenzato dal campo elettrico , che è sempre ortogonale al campo magnetico .

3. Prestiamo attenzione a questo , che ogni particella del micromondo ha altri tre gradi di libertà , che vengono utilizzati per il movimento rotatorio . Vedi fig. 1 . Lo dice il fisico Hopkins , che lo spazio può trasformarsi in tempo e viceversa . Come comprendere questa affermazione ? Conosciamo la legge di conservazione dell'energia , che recita : la somma dell'energia cinetica e potenziale di un corpo è costante . Il moto di una particella nello spazio del microcosmo è oscillatorio . Il moto oscillatorio è il risultato della somma di due movimenti : traslazionale e rotazionale . L'energia cinematica è l'energia del movimento traslazionale , e il potenziale è l'energia immagazzinata di un corpo immobile nello spazio in diversi modi . Il movimento di traslazione viene effettuato nello spazio , e rotazionali nel tempo e questi movimenti hanno condizioni al contorno matematiche , di cui ci ha parlato il fisico Hopkins .

4. Credo , che tutte le particelle dell'ultramicrocosmo differiscono l'una dall'altra solo per la frequenza di vibrazione . Per esempio , ultravioletti e infrarossi : lo stesso fotone , ma con frequenze diverse . Credo , quella frequenza è una forma di accumulo di energia , T .e. la frequenza determina la quantità di energia cinetica e potenziale di una particella . Poiché la formula di Einstein tiene conto solo dell'energia cinetica di una particella in movimento , allora questa formula necessita di aggiustamenti . Apparentemente , Per massa di una particella dobbiamo comprendere la massa specifica , T . e . massa di volume creata dalla frequenza di vibrazione : la massa della particella deve essere divisa per il prodotto dell'ampiezza della vibrazione e l'area della lunghezza d'onda o l'aspettativa matematica di quest'onda.

5. Ogni particella elementare del microcosmo contiene un proprio tipo specifico di ultramicroparticelle con una propria frequenza. Per esempio , gli elettroni contengono fotoni della stessa frequenza ( sotto il nuovo nome: “ bioni ”), ma la frequenza del fotone emesso è adattata alle condizioni dell'orbita specifica dell'elettrone . La Figura 4 fornisce la prova di questa ipotesi. : tutte le onde elettromagnetiche devono avere la stessa lunghezza e ampiezza in un'orbita particolare . Ma la transizione dall'orbita all'altra orbita è accompagnata da un cambiamento nei parametri di frequenza : T . e . ampiezza e lunghezza d'onda . Ogni orbita ha il proprio livello di energia potenziale ep già , come conseguenza della legge di conservazione dell’energia . Motivo pag e La fuga regolare dell'energia dei quark da una particella elementare del micromondo può causare fenomeni di risonanza .

Un blocco di elettroni in orbita ha una coppia , che è il prodotto della massa dell'elettrone per il raggio orbitale , che porta alla rotazione delle orbite stesse . Ciascuna orbita di elettroni in un atomo è intrinsecamente un circuito elettrico chiuso e quindi crea un campo elettromagnetico attorno a sé. Pertanto, la velocità degli elettroni in orbita è la stessa , come in un circuito elettrico . Questo campo impedisce agli elettroni di avvicinarsi ai protoni del nucleo . La direzione delle linee del campo magnetico può essere determinata utilizzando la regola del succhiello .

7 . La letteratura fisica lo indica , che l'elettrone ha spin 2. Infatti , Quando un fotone viene rilasciato, ruota di 90 gradi , T . e . entro 1 / 2 lo schienale ritorna nella sua posizione originale , che dà 1 in più / 2 indietro . Poi cambia il limite del turno e ancora 1 / 2 e 1 / 2 , T . e . la rotazione totale è 2 .

7. Il nostro universo - spazio fisicamente chiuso . È limitato da costanti fisiche : Per esempio , la velocità della luce è di 300.000 km al secondo oppure il limite di temperatura è 273 , 16 gradi Celsius . Obbedisce quindi alla Legge di Conservazione dell'Energia e quindi esiste già da miliardi di anni . Come si può spiegare questo fatto? , che il movimento dei pianeti nelle orbite non si è fermato ? Supponendo , che i pianeti si muovono per inerzia dopo l'impulso dell'Esplosione , quindi questa energia nel corso di miliardi di anni andrebbe persa in una certa misura a causa degli incontri con meteoriti e con il vento solare. Nota , che le particelle del mondo ultramicro, quando si muovono, eseguono movimenti oscillatori attorno alla loro traiettoria di movimento, T . e . il loro movimento è un processo oscillatorio di una certa frequenza . Il processo oscillatorio in natura è la transizione dell'energia potenziale in energia cinetica e ritorno. Da ciò consegue che , che il movimento di qualsiasi corpo in uno spazio chiuso deve utilizzare una riserva di energia potenziale attraverso il meccanismo della frequenza.

Non sappiamo perché esistono le temperature , limiti del vuoto e velocità limitata della luce . Forse c'è il crioplasma , qualcosa come un buco nero , ene contraente P giyu in una certa misura , dopo di che avviene il Big Bang .

8. Sperimentalmente, gli scienziati non sono stati in grado di raggiungere la velocità della luce o la temperatura di zero Kelvin. . Li hanno avvicinati a questi limiti solo di una quantità asintoticamente piccola . Questi esperimenti richiedevano un enorme dispendio di energia . Così è stato stabilito , che nel caso di piccole quantità si generano enormi costi energetici . Conosciamo dalla fisica classica la formula della forza F quando le masse interagiscono : M 1 M 2 Dove R è la distanza tra le masse :

F = m 1 *M 2 /r^ 2 . Il peso di un protone o di un elettrone è circa 0 , 91 * 10 alla potenza meno 31 kg ( la massa è un ordine di grandezza inferiore ), densità 6 , 1 * 10 alla 17a potenza kg / M ^ 3 . Distanza tra particelle in interazione debole ( 2 * 10 a meno 1 5 gradi ) me con una forte interazione ( 10 alla meno 18a potenza ) conosciuto . Tuttavia, quando si calcola la forza di attrazione di queste particelle, si dovrebbe tener conto di questo fatto , che ogni microparticella è un microcircuito oscillatorio . Aspetto o spiegazione del punto 10. Questo ce lo dimostra l'applicazione della formula della fisica classica ai calcoli dell'interazione delle particelle del micromondo , che non ci sono confini tra la fisica classica e quella quantistica o relativistica .

9. Oggetti carichi , Per esempio , elettroni causare non solo un campo elettrostatico, ma anche una corrente elettrica. C’è una differenza significativa tra questi due fenomeni. Per l'emergere di un campo elettrostatico sono necessarie cariche stazionarie, in qualche modo fissate nello spazio, e per l'emergere di una corrente elettrica, al contrario, è necessaria la presenza di particelle cariche libere e non fissate, che nel campo elettrostatico delle cariche stazionarie venire in uno stato movimento ordinato lungo le linee di campo . Per esempio , scarica elettrica elettricità statica , concentrato in una nube temporalesca - fulmine . Questo movimento è elettricità .

10. Ma c'è un'altra ragione per la presenza di corrente elettrica . Ogni particella di tipo ultra e microelettrone ha la propria frequenza di vibrazione e , quindi , è un circuito micro oscillante , a cui si applica la formula di Joseph Thomson :

f = 1/2 P è la radice quadrata di L*C, Dove L = 2*EL/I quadrato E

C = 2* Ec/U quadrato , dove E 1 c ed e 1 litro è l'energia del campo elettrico e del flusso magnetico, rispettivamente . La formula mostra una relazione costante tra L( in Enrico , ) E C ( in farad , che vengono convertiti in centimetri ).

( unità di induttanza in sistema GHS; 1 cm = 1·10 -9 Gn ( Enrico ), cm , cm... capacità, Centimetro - unità di capacità in sistema GHS = 1·10 -12 F ( farad ), cm . )

Se le dimensioni di queste quantità sono in centimetri , quindi il denominatore di questa formula è la circonferenza . Quindi , il campo elettrico attorno a un elettrone è una serie di cerchi coassiali . Con un aumento del raggio del cerchio, la velocità di movimento di una particella ultra micro dovrebbe aumentare dal periodo , cioè la frequenza di vibrazione dell'elettrone -F costante . La conseguenza di ciò aumenta il consumo di energia cinetica per le particelle più distanti e diminuisce la loro capacità di indurre corrente elettrica nel conduttore.

Ma prestiamo attenzione alla Fig. 3 , dove è mostrato , che i vettori E 1 Con ed E 1 litro separati nello spazio e mutuamente ortogonali . Questa circostanza deve essere presa in considerazione quando si induce una corrente elettrica in un conduttore . Se applichiamo la legge di conservazione dell’energia alle quantità E 1 litro ed E 1 Con , poi E 1 litro è l'energia cinetica di un flusso di elettroni in movimento -IO, UN E 1 c è l'energia potenziale del campo elettrico in funzione della sua intensità U. Energia E1 l E E1c reattivo . Nel caso delle particelle del micromondo, i loro vettori sono ortogonali all'asse delle coordinate del sistema operativo , ma si trovano su piani diversi di coordinate ortogonali . (C guarda il riso . 2 ). Entrambi i vettori sono separati nello spazio . Pertanto non avviene il loro reciproco annichilamento e la frequenza delle microparticelle non decade nel tempo .

Nei circuiti elettrici, la reattanza è solitamente indicata con X , e la resistenza totale nei circuiti a corrente alternata Z, resistenza attiva - R e la somma di tutte le resistenze è chiamata impedenza . Z = R+jX

L'entità dell'impedenza è il rapporto tra le ampiezze di tensione e corrente, mentre la fase è la differenza tra le fasi di tensione e corrente.

Se X >0 la reattanza si dice induttiva

Se X =0 si dice che l'impedenza è puramente resistiva (attiva)

Unione Europea se X <0 говорят, что реактивное сопротивлние является ёмкостным .

In un vero circuito oscillatorio , usato , Per esempio , nell'ingegneria radiofonica , possiamo compensare l'energia reattiva induttiva con energia reattiva capacitiva perché con reattanza capacitiva il vettore di corrente guida la tensione, e con reattanza induttiva il vettore di corrente è in ritardo di 90 gradi rispetto alla tensione e sono sullo stesso piano ma non contemporaneamente. Poiché una delle caratteristiche dell'induttanza è la capacità di mantenere costante la corrente che la attraversa, quando scorre la corrente di carico, sfasamento tra corrente e tensione (la corrente “ritarda” rispetto alla tensione di un angolo di fase). Diversi segni di corrente e tensione durante il periodo di sfasamento, di conseguenza, portano ad una diminuzione dell'energia dei campi elettromagnetici delle induttanze, che viene reintegrata dalla rete. Per la maggior parte dei consumatori industriali, ciò significa quanto segue: lungo le reti tra la fonte di elettricità e il consumatore, oltre all'energia attiva che svolge lavoro utile, scorre anche l'energia reattiva che non svolge lavoro utile.

Da quanto sopra ne consegue che , cosa d Per l'esistenza della corrente elettrica è necessario fornire energia dall'esterno al conduttore sotto forma elettromagnetico campi.

Spiegazione aggiuntiva . Capacità R aumenta con il numero di spire dell'elettromagnete .

R = 1/(2 π * C * f), Dove F- frequenza , E C- capacità .

Induttanza L=N 2 * μ *Al,

Dove L- induttanza , N- numero di spire del filo conduttore, µ - coefficiente di permeabilità magnetica del nucleo , UN- volume principale , io- lunghezza media del nucleo .

f = 1/(2 π * √ (L * C))

Quindi , R = 1/(4π 2 *C*N*√( μ*A/l)).

Per comprendere le proprietà di un fotone, conduciamo un semplice esperimento. Lasciamo cadere due palline dello stesso peso dalla stessa altezza su una piastra d'acciaio. Una palla è fatta di plastilina e l'altra è una palla- acciaio. È facile notare che l'entità del rimbalzo dalla piastra è diversa per loro ed è maggiore per una sfera d'acciaio. L'entità del rimbalzo è determinata dalla deformazione elastica dei materiali della sfera. Ora indirizziamo un fascio di luce sul fornelloUN , cioè un flusso di fotoni. Dall'ottica è noto che l'angolo di incidenza del raggio è strettamente uguale all'angolo di riflessione. Quando due corpi si scontrano si scambiano energia in proporzione alle loro masse. Nel caso di un fascio di fotoni, quest'ultimo modifica solo il vettore di movimento. Non consegue da questo fatto che esiste un valore insolitamente alto di deformazione elastica del fotone, cioè di superelasticità? Dopotutto, conosciamo il fenomeno della superplasticità di alcune leghe.

11. Qual è il ruolo della deformazione elastica nel microcosmo? Sappiamo che una molla compressa ha energia potenziale, maggiore è la sua grandezza, maggiore è la deformazione elastica della molla. Sappiamo che durante il processo oscillatorio l'energia potenziale si trasforma in energia cinetica e viceversa. È anche noto che tutte le particelle del micromondo subiscono un movimento oscillatorio, cioè hanno una propria frequenza di oscillazione, che crea un campo elettromagnetico attorno alla particella. Pertanto, ogni particella del microcosmo è un microcircuito oscillatorio come un circuito oscillatorio della radioingegneria. Pertanto, il campo elettromagnetico deve creare una coppia nella particella:M = r io *F io , IO - dove si trova un certo punto di applicazione di questo momento. Si noti che la frequenza della microparticella non cambia nel tempo. Pertanto, l'entità della coppia e l'entità della corrente elettrica che la provoca non cambiano nel tempo. E questo è possibile solo nel caso della superconduttività!

Questa coppia fa ruotare la particella attorno agli assi X e Y in sequenza, creando una deformazione torsionale elastica. Queste deformazioni superelastiche riportano la particella al suo stato originale. In questo modo si crea un movimento oscillatorio della particella con la transizione dell'energia potenziale insita nella deformazione torsionale elastica nell'energia cinetica del movimento della particella nello spazio lungo l'asseZ .

Il meccanismo di tale transizione può essere immaginato come la torsione di un tubetto di pasta. Infatti la variazione di volume porta all'estrusione della pasta dal foro del tubo, posto perpendicolarmente al piano di torsione del tubo. Questo impulso interno fa sì che la particella si muova lungo l'asseZ. Emerge un nanomotore ad alta efficienza. Qualcosa di simile si può osservare nella cosiddetta ruota della lavanderia. Se l'asse di tale ruota non è fisso, invece di una ruota rotante otterremo un movimento di rotolamento traslatorio. Per implementare questo motore, è necessario creare un materiale con valori insolitamente elevati di deformazione torsionale elastica. Allora si aprirà la strada da percorrere alla velocità della luce.

12. Proprietà così estremamente elevate delle microparticelle si verificano nei materiali a temperature prossime allo zero Kelvin. La materia non viene periodicamente contratta in una sorta di buco nero, che rappresenta il crioplasma alla temperatura Kelvin? Non è questa materia, grazie alle sue proprietà soprannaturali, un accumulatore di energia potenziale che, quando raggiunge un livello critico, viene convertita in energia cinetica da un'esplosione?

LA FISICA QUANTISTICA

Fisica quantistica − branca della fisica che studia i fenomeni caratteristici del micromondo, cioè oggetti aventi dimensioni pari o inferiori a 10 -10 me inferiori. La specificità dei fenomeni che si verificano nel microcosmo risiede principalmente nell'impossibilità di direttamente, cioè. attraverso i sensi (principalmente la vista) per ottenere informazioni sui processi in corso. Per descrivere i fenomeni del micromondo sono necessari approcci e metodi fondamentalmente nuovi, basati su quantità misurate sperimentalmente.

La nascita della fisica quantistica fu preceduta da una situazione drammatica che si sviluppò in fisica proprio alla fine del XIX secolo. La fisica classica non era in grado di descrivere adeguatamente lo spettro della radiazione di equilibrio. A quel tempo la radiazione termica era considerata come un insieme di onde piane e la sua descrizione teorica era in buon accordo con quella sperimentale. Tuttavia, alle alte frequenze la densità di energia della radiazione prevista dovrebbe aumentare all’infinito. Questa situazione fu chiamata il “disastro ultravioletto”.

Una via d'uscita inaspettata dalla situazione è stata proposta dal fisico tedesco Max Planck (Max Karl Ernst Ludwig Planck). La sua idea era che la radiazione avviene in quanti separati e l'energia di un'onda elettromagnetica non può essere arbitraria, come si credeva nella fisica classica, ma deve assumere determinati valori proporzionali a un certo valore molto piccolo h (pari a 6,63 10 -34 J s), che venne poi nominato Costante di Planck. Allora la densità di energia totale non può più essere considerata un valore continuo, ma consiste di molte porzioni di energia (quanti), la cui somma non può essere così grande come previsto dalle ipotesi classiche. Il problema della densità della radiazione e della “catastrofe ultravioletta” è stato risolto con successo. Per la scoperta del quanto di energia nel 1918, Max Planck ricevette il Premio Nobel.

L’introduzione dei quanti permise di risolvere una serie di altri problemi che la scienza si trovava allora ad affrontare. Utilizzando l'idea di Planck del quanto di energia, Albert Einstein nel 1905 derivò l'equazione dell'effetto fotoelettrico E = hν + W, dove E è l'energia cinetica degli elettroni, ν è la frequenza della radiazione elettromagnetica, h è la costante di Planck e W è la funzione lavoro degli elettroni per una data sostanza. Il risultato più importante in questo caso è stata l'introduzione dell'energia della radiazione elettromagnetica in funzione della frequenza (o lunghezza d'onda) della radiazione, che ha portato alla successiva creazione della scala delle onde elettromagnetiche.

L'idea di un quanto portò alla conclusione sulla natura discreta dei fenomeni che si verificano nel microcosmo, che fu successivamente utilizzata nello studio dei livelli energetici degli atomi e dei nuclei atomici.

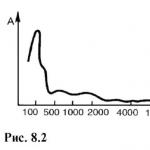

Dipendenza della lunghezza d'onda di vari tipi di particelle dalla loro energia

(unità nucleari − MeV = 1,6·10 -13 J, fm =10 -15 m)

Un'altra importante conseguenza della discrezionalità dei fenomeni del micromondo fu la scoperta da parte di Louis de Broglie (1929) dell'universalità della dualità onda-particella, cioè il fatto che gli oggetti del micromondo hanno sia natura ondulatoria che corpuscolare. Ciò ha permesso non solo di spiegare una serie di fenomeni associati all'interazione delle particelle con la materia (ad esempio la diffrazione delle particelle), ma anche di sviluppare ulteriormente metodi per utilizzare le radiazioni per influenzare le particelle, che hanno portato alla creazione dei principali metodi moderni strumento per studiare la materia: acceleratori.

Nella seconda metà degli anni '20 del XX secolo fu creato un apparato teorico per la descrizione dei fenomeni quantistici: meccanica quantistica. I contributi più significativi alla sua creazione furono forniti da Werner Heisenberg, Erwin Schrödinger, Niels Bohr, Paul Dirac, Wolfgang Pauli, Max Born e altri.

La meccanica quantistica è una parte separata e ben sviluppata della fisica moderna. Per la sua profonda assimilazione è necessaria una buona preparazione matematica, che va ben oltre l'ambito del corso di fisica in molte università. Tuttavia, le spiegazioni dei concetti base della meccanica quantistica non sono così difficili. Questi concetti basilari comprendono innanzitutto il significato fisico della quantizzazione, il principio di indeterminazione e la funzione d'onda.

Il significato fisico della discrezione degli stati nel microcosmo è, innanzitutto, associato al significato fisico della costante di Planck. Determina la piccolezza delle sue dimensioni scala delle interazioni in un microcosmo. Infatti, quando si passa al macromondo e ai concetti classici, quantità come la costante di Planck diventano trascurabilmente piccole e nella maggior parte dei casi le consideriamo pari a zero. In questo caso si verifica il cosiddetto passaggio al limite, ovvero i principi della fisica classica possono essere considerati come una versione estrema della fisica quantistica, quando le masse, le dimensioni e altri parametri dei macrooggetti, enormi sulla scala del micromondo, riducono a zero quelle interazioni che sono significative nel micromondo. Possiamo quindi dire che la costante di Planck è l’anello di congiunzione tra i fenomeni del micro e del macro mondo.

Ciò può essere visto particolarmente bene nell'esempio della discrezione degli stati nel microcosmo. Ad esempio, la differenza tra gli stati energetici di un atomo può essere di decimi di elettronvolt (unità di energia del microcosmo pari a 1,6·10 -19 J). Basti ricordare che sono necessarie decine di kilojoule per far bollire un bicchiere d'acqua, e diventa chiaro che dal punto di vista della fisica classica tale discrezione è assolutamente impercettibile! Ecco perché possiamo parlare della continuità dei processi che ci circondano, nonostante la discrezione di lunga data e costantemente confermata di quei fenomeni che si verificano negli atomi e nei nuclei atomici.

Per lo stesso motivo, un principio così fondamentale della fisica del micromondo come principio di indeterminazione, proposto da W. Heisenberg nel 1927

La figura seguente spiega la necessità di introdurre il principio di incertezza nel micromondo e l'assenza di questa necessità nel macromondo

Infatti, il grado di influenza di una sorgente esterna (luce) su un macrooggetto (statua) non è commisurato ai suoi parametri (ad esempio, la massa convertita in energia equivalente): non ha senso parlare di come un fotone di luce incidente possa influenzano, ad esempio, le coordinate di una statua nello spazio.

Un’altra cosa è quando un microoggetto diventa oggetto di influenza. L'energia di un elettrone in un atomo è di decine (raramente di più) elettronvolt e il grado di impatto è abbastanza commisurato a questa energia. Quindi, quando ci provi misurare accuratamente qualsiasi parametro di un microoggetto (energia, quantità di moto, coordinate), ci troveremo di fronte al fatto che il processo di misurazione stesso cambierà i parametri misurati, e in modo molto forte. Allora bisogna ammettere che con qualsiasi misurazione nel microcosmo non saremo mai in grado di effettuare misurazioni precise − Sempre si verificherà un errore nella determinazione dei parametri di base del sistema. Il principio di indeterminazione ha un'espressione matematica nella forma relazioni di incertezza, ad esempio ΔpΔx ≈ ћ, dove Δp è l'incertezza nel determinare la quantità di moto, e Δx è l'incertezza nel determinare le coordinate del sistema. Si noti che la costante di Planck sulla destra indica i limiti di applicabilità del principio di incertezza, perché nel macrocosmo possiamo tranquillamente sostituirla con zero ed eseguire misurazioni accurate di qualsiasi quantità. Il principio di indeterminazione porta alla conclusione che è impossibile fissare con precisione qualsiasi parametro del sistema; ad esempio, non ha senso parlare della posizione esatta di una particella nello spazio. A questo proposito va notato che la diffusa rappresentazione di un atomo come un insieme di elettroni rotanti in date orbite attorno al nucleo è semplicemente un omaggio alla percezione umana del mondo circostante, alla necessità di avere delle immagini visive in davanti a se stessi. In realtà, non esistono traiettorie chiare: orbite nell'atomo.

Tuttavia, ci si può chiedere: qual è allora la caratteristica principale dei sistemi nel micromondo, se parametri come energia, quantità di moto, tempo di interazione (o esistenza), coordinate non sono definiti? Una quantità così universale è Funzione d'onda sistema quantistico.

La funzione d'onda ψ, introdotta da Max Born per determinare le caratteristiche di un sistema quantistico, ha un significato fisico piuttosto complesso. Un'altra grandezza più chiara è il modulo quadrato della funzione d'onda |ψ| 2. Questo valore determina, ad esempio, probabilità che il sistema quantistico si trova in un dato momento. In generale, il principio probabilistico è fondamentale nella fisica del micromondo. Qualsiasi processo in corso è caratterizzato principalmente dalla probabilità che si verifichi con determinate caratteristiche.

La funzione d'onda è diversa per i diversi sistemi. Oltre alla conoscenza della funzione d'onda, per descrivere correttamente un sistema sono necessarie anche informazioni su altri parametri, ad esempio le caratteristiche del campo in cui il sistema si trova e con il quale interagisce. Lo studio di tali sistemi è proprio uno dei compiti della meccanica quantistica. La fisica quantistica, infatti, forma un linguaggio con cui descriviamo i nostri esperimenti e risultati nello studio del micromondo, più generale della teoria classica. Allo stesso tempo, è importante comprendere che la fisica quantistica non annulla la fisica classica, ma la contiene come caso limite. Quando si passa dai microoggetti agli oggetti macroscopici ordinari, le sue leggi diventano classiche e, quindi, la fisica quantistica pone i limiti di applicabilità della fisica classica. Il passaggio dalla fisica classica alla fisica quantistica è un passaggio ad un livello più profondo di considerazione della materia.

I processi che avvengono nel microcosmo si riferiscono a fenomeni che si trovano quasi completamente oltre i limiti della percezione sensoriale. Pertanto, i concetti su cui opera la teoria quantistica e i fenomeni che essa considera sono spesso privi di chiarezza ,

inerenti alla fisica classica. Con lo sviluppo della teoria quantistica, le idee apparentemente ovvie e familiari su particelle e onde, discrete e continue, descrizioni statistiche (probabilistiche) e dinamiche furono riviste. La fisica quantistica è diventata il passo più importante nella costruzione di un quadro fisico moderno del mondo. Ha permesso di prevedere e spiegare un numero enorme di fenomeni diversi: dai processi che si verificano negli atomi e nei nuclei atomici agli effetti macroscopici nei solidi; senza di essa è impossibile, come sembra adesso, comprendere l'origine dell'Universo. La gamma della fisica quantistica è ampia: dalle particelle elementari agli oggetti cosmici. Senza la fisica quantistica, non solo le scienze naturali, ma anche la tecnologia moderna sono impensabili.

FISICA ATOMICA

Nel 1885 J.J. Thomson scoprì l'elettrone, il primo oggetto del microcosmo. È stato posto l'inizio per l'emergere di un nuovo ramo della scienza: la fisica atomica. Già all'inizio del XX secolo esistevano diversi modelli della struttura dell'atomo, di cui il più famoso apparteneva allo stesso J. J. Thomson. Secondo questo modello, l'atomo era una carica positiva localizzata in un piccolo volume, nel quale, come l'uvetta in un cupcake, c'erano gli elettroni. Questo modello spiegava una serie di effetti osservati, ma non era in grado di spiegarne altri, in particolare la comparsa di spettri atomici a righe. Nel 1911, un connazionale di Thomson, Ernest Rutherford, cercò di rispondere alla domanda sulla struttura dell'atomo.

Il disegno sperimentale era semplice: una sorgente, una sostanza radioattiva che emette nuclei di elio, era collocata in un blocco di piombo. Le particelle cariche passavano attraverso la sottile lamina d'oro e venivano disperse interagendo con gli atomi d'oro. Le particelle disperse colpiscono poi uno schermo rivestito con una sostanza in cui provocano scintillazioni (bagliori). L'idea era che se il modello dell'atomo di Thomson fosse corretto, l'interazione si sarebbe verificata approssimativamente allo stesso modo a tutti gli angoli lungo il percorso delle particelle. Infatti, la maggior parte delle particelle colpisce lo schermo, interagendo debolmente con il materiale della lamina. Ma una piccola parte (circa 8 particelle su mille) ha subito una forte dispersione ALL'INDIETRO, come se entrasse in collisione con una sorta di carica concentrata nel mezzo dell'atomo. Dopo numerosi esperimenti, Rutherford concluse che il modello di Thomson non era corretto. Propose un modello, in seguito chiamato planetario. Al centro, in un piccolo volume, è concentrata tutta la carica positiva (nucleo), attorno ad essa si trovano gli elettroni.

Il modello di Rutherford era buono, ma non rispondeva ancora a una serie di domande. Ad esempio, come si verifica la radiazione atomica (luminescenza)? In quali circostanze gli atomi emettono fotoni luminosi diversi? Da cosa dipende questo? L'emissione degli atomi è legata al comportamento degli elettroni al loro interno? Le risposte a queste domande furono date due anni dopo dall'eccezionale fisico danese Niels Henrik David Bohr.

L'immagine di N. Bohr sulla banconota da 500 corone danesi.

Bohr sviluppò il modello planetario, suggerendo che ogni elettrone in un atomo ha uno stato energetico fisso (che può essere descritto in modo molto approssimativo come se l'elettrone si trovasse in un'orbita). Mentre l'atomo si trova nello stato energetico più basso, non può irradiare. Quando ricevono energia dall'esterno, gli elettroni possono cambiare il loro stato energetico (spostarsi su un'altra orbita) o addirittura lasciare l'atomo (ionizzazione). Quando ritorna al suo posto (o nella sua orbita), l'energia in eccesso viene rilasciata sotto forma di radiazione caratteristica (un fotone di qualsiasi energia). L'atomo “secondo Bohr” ha risposto a tutte le domande sorte dopo la creazione dei primi modelli atomici. Lo studio sperimentale degli atomi ha confermato con successo il modello di Bohr e, tra l'altro, le previsioni quantistiche sulla discrezionalità delle energie nell'atomo. Nel 1922 Niels Bohr ricevette il Premio Nobel per il suo lavoro sulla struttura degli atomi e sulla loro radiazione.

Già negli anni '20 del secolo scorso l'atomo era ben studiato. Il successo è stato facilitato anche dal fatto che la connessione tra i componenti dell'atomo - il nucleo e gli elettroni - è stata effettuata grazie al noto potenziale di Coulomb. Alla fine degli anni '20 nacque la teoria quantistica, che descriveva un numero di atomi e i modelli del loro comportamento.

Gli atomi sono sistemi quantistici elettricamente neutri con dimensioni caratteristiche dell'ordine di 10 -10 M. Ogni atomo contiene un nucleo in cui è concentrata la carica positiva dell'atomo e quasi tutta la massa dell'atomo (più del 99,9%). La carica negativa è distribuita tra gli elettroni, il loro numero è uguale al numero di particelle nucleari caricate positivamente (protoni) nel nucleo. Quando una certa energia, chiamata energia di ionizzazione, viene applicata a un atomo, uno degli elettroni lascia l'atomo. Viene chiamata la restante parte caricata positivamente ione, e questo processo è la ionizzazione. Il processo inverso si chiama ricombinazione ed è accompagnato dall'emissione di un fotone con un'energia corrispondente alla differenza tra le energie dell'atomo prima e dopo la ricombinazione.

La ionizzazione è un processo che avviene costantemente intorno a noi. Le fonti di ionizzazione sono la radiazione cosmica, vari strumenti e dispositivi e fonti radioattive.

Sulla base delle proprietà degli atomi sopra descritte, funziona un gran numero di dispositivi tecnici. Un esempio che incontriamo ogni giorno sono le lampade fluorescenti. È il bagliore del gas derivante dalla ricombinazione degli ioni che provoca l'emissione di luce in questi dispositivi.

Negli anni '50 del secolo scorso, come risultato dello studio delle proprietà dell'emissione stimolata di fotoni da un numero di atomi, furono sviluppati amplificatori di radiazioni ottiche - laser. (dall'abbreviazione Amplificazione della luce mediante emissione stimolata di radiazioni − amplificazione della luce mediante emissione stimolata). Un laser non è un dispositivo ottico come i leggendari scudi a specchio di Archimede, ma un dispositivo quantistico che utilizza la struttura dei livelli atomici per amplificare otticamente la radiazione. Il vantaggio principale di un laser è l’elevata monocromaticità (ovvero tutti i fotoni emessi hanno quasi la stessa lunghezza d’onda) della radiazione che genera. È per questo motivo che i laser sono attualmente ampiamente utilizzati nell'elettronica e nella tecnologia industriale e di consumo, nella medicina e in altri campi.

FISICA DEL NUCLEO ATOMICO

Nel 1911 Ernest Rutherford propose il suo modello dell'atomo, al centro del quale si trovava un oggetto delle dimensioni di circa 10 -15 − 10 -14 m, contenente quasi l'intera massa dell'atomo. Questo oggetto è stato nominato nucleo atomico. Tuttavia, non sorprende che lo studio del nucleo atomico sia iniziato molto prima, alla fine del XIX secolo. È vero, a quel tempo le proprietà dei nuclei atomici venivano attribuite ad atomi la cui struttura era precisamente sconosciuta.

IN  1896 Antoine Becquerel, studiando la radiazione degli atomi di alcuni metalli pesanti, giunse alla conclusione che le particelle da essi emesse, a differenza della luce, tendono a penetrare nelle sostanze dense. Dopo 3 anni, continuando gli esperimenti con sostanze radioattive, Ernest Rutherford pose il minerale di uranio in un campo magnetico e scoprì che il raggio primario si divideva in 3 parti, un tipo di particelle deviava verso il polo nord del magnete, il secondo verso sud, e il terzo passò senza cambiamenti. Non conoscendo ancora la natura di queste radiazioni, Rutherford le chiamò con i nomi delle prime tre lettere dell'alfabeto greco: α, β e γ. Oltre a Becquerel e Rutherford, studi simili furono condotti anche dai coniugi Curie Pierre e Marie (Sklodowska-Curie). Marie Curie diede un enorme contributo allo studio della radioattività nei nuclei atomici, fu la prima a ottenere il radio metallico e fu tra quegli scienziati che crearono la fisica nucleare sperimentale. È l'unica scienziata ad aver ricevuto due premi Nobel (per la chimica e la fisica).

1896 Antoine Becquerel, studiando la radiazione degli atomi di alcuni metalli pesanti, giunse alla conclusione che le particelle da essi emesse, a differenza della luce, tendono a penetrare nelle sostanze dense. Dopo 3 anni, continuando gli esperimenti con sostanze radioattive, Ernest Rutherford pose il minerale di uranio in un campo magnetico e scoprì che il raggio primario si divideva in 3 parti, un tipo di particelle deviava verso il polo nord del magnete, il secondo verso sud, e il terzo passò senza cambiamenti. Non conoscendo ancora la natura di queste radiazioni, Rutherford le chiamò con i nomi delle prime tre lettere dell'alfabeto greco: α, β e γ. Oltre a Becquerel e Rutherford, studi simili furono condotti anche dai coniugi Curie Pierre e Marie (Sklodowska-Curie). Marie Curie diede un enorme contributo allo studio della radioattività nei nuclei atomici, fu la prima a ottenere il radio metallico e fu tra quegli scienziati che crearono la fisica nucleare sperimentale. È l'unica scienziata ad aver ricevuto due premi Nobel (per la chimica e la fisica).

Tuttavia, i veri progressi nello sviluppo della fisica del nucleo atomico si sono verificati dopo la creazione della meccanica quantistica. Dopotutto, dopo nel 1911-1913. Rutherford e Bohr scoprirono la struttura dell'atomo, sorse la domanda: qual è la struttura del nucleo atomico? Rutherford tentò di rispondere dirigendo nel 1918-21. esperimenti sullo studio dei nuclei atomici leggeri. Fu lui a realizzare per la prima volta nel 1919 reazione nucleare e aperto protone

14 N + 4 He → 17 O + p

L'azoto, interagendo con i nuclei di elio (particelle α), è stato convertito in ossigeno e idrogeno. In effetti, Rutherford fu il primo a realizzare ciò che sognavano gli alchimisti medievali: la trasformazione di una sostanza in un'altra.

L'emissione di un protone dal nucleo confermò l'idea della presenza di protoni nel nucleo. Allo stesso tempo, è diventato chiaro che le masse dei nuclei sono molto maggiori che se consistessero del numero richiesto di protoni. Poi è nata l'idea del modello protone-elettrone del nucleo, gli elettroni nel nucleo compensavano la carica di alcuni dei protoni che erano lì, come si suol dire, "per peso".

I successi della meccanica quantistica portarono ben presto al fatto che la possibilità dell'esistenza degli elettroni nei nuclei era in dubbio: secondo il principio di indeterminazione, un elettrone posto in un nucleo avrebbe dovuto avere troppa energia e non poteva essere trattenuto lì . Nel 1931, Heisenberg, Ivanenko e Majorana, indipendentemente l'uno dall'altro, proposero l'idea di un "protone neutro" - una particella pesante senza carica situata nel nucleo atomico. La chiarezza finale arrivò nel 1932, quando James Chadwick lo scoprì neutrone– una particella neutra con una massa approssimativamente uguale alla massa di un protone. Il moderno, dunque modello protone-neutrone nucleo atomico.

Il principale difetto nella nostra conoscenza del nucleo atomico è la mancanza di una forma esatta potenziale nucleare, che lega i nucleoni. Risolvere il problema della creazione di una teoria completa del nucleo è il più importante nella fisica nucleare. Allo stesso tempo, sappiamo molto sulla struttura del nucleo atomico.

Il nucleo atomico è un oggetto con dimensioni dell'ordine di 10 -15 m, costituito da due tipi di particelle: protoni e neutroni. La loro massa è di circa 1,7·10 -27 kg e il neutrone è lo 0,14% più pesante del protone. A causa della somiglianza nelle proprietà (ad eccezione della presenza di carica), entrambe le particelle sono spesso chiamate la parola “ nucleone».

Attualmente si conoscono circa 3.400 nuclei atomici. Di essi 330 sono stabili, i restanti possono trasformarsi spontaneamente in altri nuclei (radioattivi) in un tempo abbastanza breve. Vengono chiamati nuclei che hanno lo stesso numero di protoni ma diverso numero di neutroni isotopi lo stesso elemento. Ad esempio, l'idrogeno ha tre isotopi: l'idrogeno stesso, il deuterio e il trizio radioattivo. Ma lo stagno ha più di 30 isotopi, la maggior parte dei quali sono radioattivi.

Il nucleo atomico è un sistema quantistico che obbedisce alle leggi della fisica quantistica. Il nucleo atomico ha una struttura energetica discreta. È vero, non ha una struttura “planetaria”, come in un atomo, ma esistono anche diverse posizioni energetiche dei nucleoni, chiamate livelli energetici. Quando ricevono una porzione di energia, i nucleoni nel nucleo si spostano in uno stato energetico più elevato e quando ritornano indietro emettono energia sotto forma di fotoni con una lunghezza d'onda corta. Tali fotoni nucleari sono solitamente chiamati γ -quanti. Una volta raggiunta l'energia chiamata energia di separazione del nucleone, il nucleo può espellere un nucleone, modificandone la composizione e le proprietà. Il numero di nucleoni di diverso tipo nel nucleo e il loro stato energetico determinano le proprietà dei nuclei atomici e caratteristiche più fondamentali. Ad esempio, l'abbondanza di elementi nell'Universo è spiegata proprio dalle caratteristiche quantistiche dei nuclei atomici.

Quando i nucleoni si combinano in nuclei, si osserva un effetto interessante: la massa del nucleo risultante risulta essere leggermente (circa l'1%) inferiore alla massa dei nucleoni costituenti. La differenza tra la massa dei nucleoni e la massa del nucleo contribuisce al legame dei nucleoni nel nucleo ed è quindi chiamata energia di legame

E св = ZМ p с 2 + (A-Z)М n с2 − М i с 2,

dove Z è la carica nucleare, A lo è numero di Massa(numero di nucleoni nel nucleo)

L'energia di legame è una quantità estremamente importante, che determina anche molte proprietà dei nuclei. Una quantità altrettanto importante è energia di legame specifica, cioè. rapporto tra energia di legame e numero di nucleoni

Dipendenza dell'energia di legame specifica dal numero di nucleoni

Si può notare che questa dipendenza ha un massimo evidente nella regione del nucleo 56 Fe (per questo è chiamata anche “massimo del ferro”). Questa circostanza, senza esagerare, è di enorme importanza pratica.

Alla fine degli anni '30 del secolo scorso, durante lo studio dei nuclei pesanti, fu stabilito un modello di graduale diminuzione dell'energia di legame specifica. Di conseguenza, al diminuire di questo valore, il nucleo diventa più instabile e “allentato”. Inoltre, sotto un certo impatto, può iniziare a emettere nucleoni o addirittura cadere a pezzi. Nel 1939, i fisici tedeschi Otto Hahn e Fritz Strassman, irradiando i sali di uranio con neutroni termici, scoprirono il bario tra i prodotti della reazione. Ciò significava che, sotto un'influenza minima (l'energia dei neutroni termici corrisponde all'energia delle molecole di gas a temperatura ambiente), uno degli isotopi dell'uranio è in grado di scindersi. Tuttavia, la cosa principale non era questa, ma il fatto che, come risulta dal diagramma sopra, i nuclei del frammento risultante avranno un'energia di legame specifica molto più elevata, cioè sarà più saldamente connesso. Pertanto, durante la fissione ci sarà una differenza di energia e questa differenza verrà rilasciata. Il decennio e mezzo successivo portò questa scoperta all’uso pratico. Il primo fu lanciato nel 1942 reattore nucleare(USA), il primo venne fatto saltare in aria nel 1945 bomba nucleare(USA), nel 1954 - fu lanciata la prima centrale nucleare (URSS).

Come viene recuperata in pratica l'energia dalla fissione? Immaginiamo di avere una quantità sufficiente di campione di una sostanza che si fissa con un piccolo impatto (neutroni termici). Dopo il primo atto di fissione, oltre ai nuclei frammentati, verranno rilasciati diversi neutroni con energia molto più elevata di quella dei neutroni termici. Divideranno i nuclei che incontrano lungo il percorso, come risultato di questo processo, in ogni nuovo nucleo diviso si formeranno nuovi neutroni, che, a loro volta, divideranno nuovi nuclei, ecc. Il processo avrà la natura di una valanga e per questo motivo viene chiamato reazione a catena divisione.

Un processo simile si realizza in una carica nucleare e porta ad un colossale rilascio di energia in un tempo breve (diversi millisecondi). L'esplosione di una carica di diversi chilogrammi, ad esempio 239 Pu, è simile all'esplosione di diverse centinaia di kilotoni (!) di un esplosivo convenzionale.

Esiste però un modo per estendere questo processo nel tempo. Se guardi il diagramma di una reazione a catena, puoi vedere che un fattore importante è il numero di neutroni che dividono i nuclei. Pertanto, inserendo nel materiale fissile una sostanza in grado di catturare neutroni (assorbitore), è possibile rallentare questo processo sufficientemente da poter sottrarre l'energia liberata, costringendola, ad esempio, a portare ad ebollizione l'acqua e ad utilizzarla vapore per far ruotare la turbina di una centrale elettrica (NPP). Le moderne centrali nucleari utilizzano il carbonio (grafite) come assorbitore.

Se ora osserviamo la regione dei nuclei che si trovano a sinistra del "massimo del ferro", noteremo che la loro energia specifica di legame, in media, risulta essere addirittura inferiore a quella dei nuclei al massimo stesso. Pertanto, per i nuclei leggeri, è possibile un processo inverso alla fissione, la fusione. In questo caso, come nel caso della fissione, verrà rilasciata energia. Le reazioni di sintesi includono, ad esempio, la fusione dei nuclei di deuterio per formare elio.

2 H + 2 H → 3 He + n

Reazione termonucleare |

Il problema, come è facile vedere, è che in tutti i casi abbiamo a che fare con la fusione di oggetti con carica simile, i cosiddetti Barriera di Coulomb, per superare il quale è ancora necessario spendere energie. Ciò si ottiene più facilmente riscaldando le sostanze sintetizzate a temperature molto elevate (milioni di gradi). Nelle condizioni terrene, ciò è possibile solo durante un'esplosione nucleare. Pertanto, ponendo una carica nucleare in un guscio di elementi leggeri, è possibile ottenere una reazione di fusione incontrollata oppure (a causa delle elevate temperature che ne conseguono), reazione termonucleare. Per la prima volta una tale reazione (esplosione di una bomba termonucleare) fu effettuata nel 1953 (URSS).

In natura, le reazioni termonucleari avvengono nelle stelle, dove esistono tutte le condizioni per “sfondare” la barriera di Coulomb. Inoltre la più forte compressione gravitazionale favorisce anche la reazione di fusione con formazione di elementi più pesanti, fino al ferro.

Il problema della realizzazione della fusione termonucleare controllata continua a rimanere irrisolto ed è uno dei più urgenti per la fisica del nucleo atomico, poiché consente di utilizzare combustibile a basso costo in quantità quasi illimitate senza conseguenze dannose per l'ambiente.

Come già notato, la composizione del nucleo atomico determina in gran parte le sue proprietà. Una delle caratteristiche nucleari più importanti che influenza il comportamento dei nuclei è il rapporto tra neutroni e protoni nei nuclei atomici. Questo si vede meglio nel cosiddetto Diagramma neozelandese.

Diagramma NZ dei nuclei atomici.

Puoi vedere diverse aree evidenti nel grafico. Uno di questi è la parte centrale, una stretta striscia di nuclei segnati in nero. Questa è la cosiddetta “valle della stabilità”, una regione di nuclei stabili che non sono soggetti a decadimento. All'aumentare del numero di neutroni (a destra della valle di stabilità), si localizzano i nuclei contrassegnati in blu. Quando c’è un eccesso di neutroni, l’energia del nucleo aumenta e diventa possibile “ritornare” nella valle della stabilità trasformando uno dei neutroni in un protone

n → p + e - + e.

Questo processo si chiama Decadimento β-meno. Un neutrone si trasforma in un protone, un elettrone e elettronico. Un neutrone può sperimentare questo decadimento al di fuori dei nuclei. Come risultato di tale decadimento, il nucleo aumenta la sua carica, spostandosi verso la regione di stabilità.

La regione rossa è la regione dei nuclei con un eccesso di protoni. Implementano il processo inverso:

p → n + e + + ν e

chiamato Decadimento β-plus. Il protone si trasforma in un neutrone, un positrone e un neutrino elettronico (le ultime due particelle sono gli “antipodi” dell'elettrone e dell'antineutrino). Va notato che poiché la massa di un protone è inferiore alla massa di un neutrone, tale decadimento avviene solo nei nuclei; allo stato libero il protone è stabile.

L'area gialla nel diagramma è l'area dei nuclei pesanti instabili. Sono caratterizzati da un altro tipo di decadimento: l'emissione di particelle α (nuclei di 4 He) o decadimento α, Questo tipo di decadimento porta ad una diminuzione sia della carica che del numero di massa e al "movimento" del nucleo verso la regione dei nuclei più leggeri. A volte questo porta a una catena di decadimenti. Per esempio,

226 Ra → 222 Rn + 4 He; 222 Rn → 208 Po + 4 He; 208 Po → 204 Pb + 4 He,

dove l'ultimo è già un nucleo stabile.

In molti casi, il nucleo risultante dal decadimento ha un eccesso di energia e si libera da essa emettendo un quanto γ, che avviene Transizione γ nel nucleo (a volte non del tutto correttamente chiamato decadimento γ).

Tutti i decadimenti nucleari sono caratterizzati da caratteristiche proprie legate alla probabilità di decadimento, al tipo di particelle emesse e alla loro energia. Tuttavia, esistono leggi generali di decadimento stabilite durante il lavoro di Becquerel e Curie. Il principale è legge del decadimento radioattivo.

N(t) = N 0 e -λt ,

dove N è il numero di nuclei radioattivi nel campione in un dato momento, N 0 è il numero di nuclei radioattivi in un certo momento iniziale e λ è la cosiddetta costante di decadimento, che caratterizza la probabilità di decadimento. La costante di decadimento non è molto conveniente per l'uso pratico, quindi viene spesso utilizzato un altro valore, T 1/2 - metà vita, che caratterizza il tempo durante il quale il numero di nuclei attivi diminuisce di 2 volte. La costante di decadimento e il tempo di dimezzamento sono legati dalla relazione

Vari nuclei di sorgenti radioattive possono avere emivite che vanno da millisecondi a miliardi di anni. Inoltre, una caratteristica importante è l'attività della sorgente (o della sua massa), che caratterizza l'intensità del decadimento in un dato momento. Intorno a noi sono costantemente presenti diversi tipi di nuclei radioattivi e due isotopi radioattivi, 40 K e 14 C, sono costantemente presenti nel corpo umano.

FISICA DELLE PARTICELLE

La fisica delle particelle è forse uno dei rami più dinamici della fisica. Per lo meno, è difficile nominare qualsiasi altra area delle scienze naturali in cui le idee sul mondo che ci circonda 40-50 anni fa sarebbero così diverse da quelle che abbiamo adesso. Ciò è dovuto, prima di tutto, ai cambiamenti nelle idee sulle particelle fondamentali e sulle interazioni avvenuti durante questo periodo nel corso degli studi sperimentali e teorici sulla materia. Quali sono oggi i principi base della fisica delle particelle?

Particelle fondamentali− un insieme di particelle che attualmente costituiscono i componenti elementari della materia. Negli anni '20 del secolo scorso esistevano solo due di queste particelle (e particelle in generale): il protone e l'elettrone. Già negli anni '50 il numero totale di particelle conosciute si avvicinava alle due dozzine e molte di esse erano considerate prive di struttura. Ora il numero totale di particelle è nell'ordine delle centinaia, ma solo poche sono veramente fondamentali. Tutte le particelle fondamentali possono essere divise in diversi grandi gruppi.